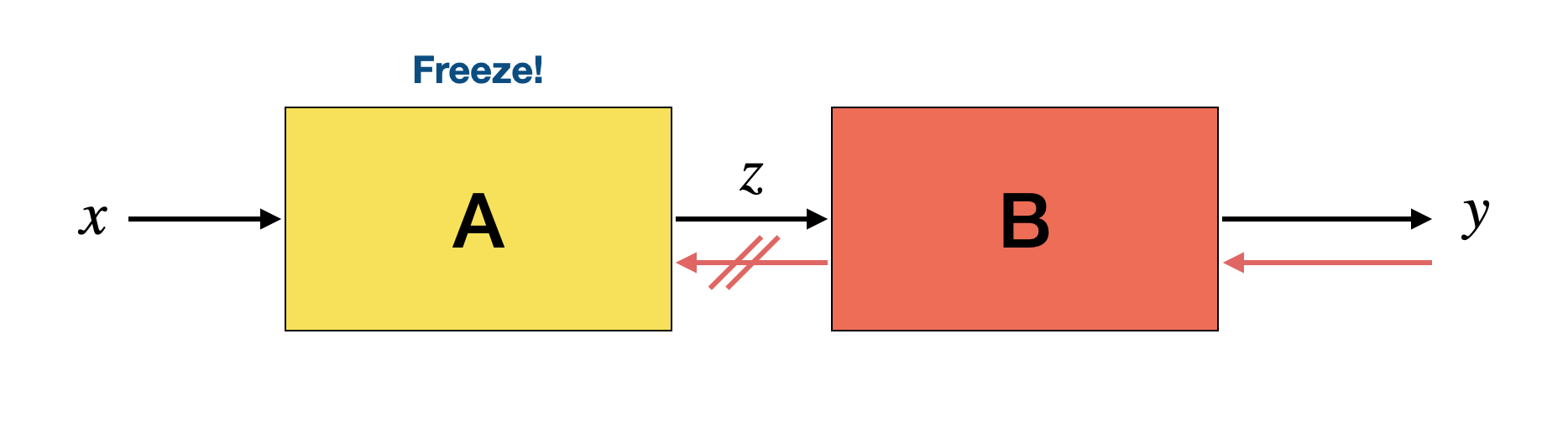

torch.Tensor.requires_grad True인 경우 해당 텐서에 대하여 gradient를 계산하여 업데이트 False인 경우 파라미터를 상수 취급하여 업데이트하지 않음 torch.no_grad gradient 계산을 하지 않게 함 inferencing할 때 활용 가능 (torch.Tensor.backward를 활용하지 않을 경우 no_grad vs. requires_grad 모델 일부는 freeze하고 일부에 대해서만 parameter update를 하고싶은 경우 활용 (ex. transfer learning, GAN) 1) 모델 A는 freeze, 모델 B만 학습 B에서 A로 가는 gradient를 막음 detach: z를 static tensor로 만들어, update할 때 z 이전 파라..